GPU实例绑定弹性RDMA网卡(ERI)后,各GPU实例间在VPC网络下可以实现RDMA直通加速互连,相比传统的RDMA,eRDMA可以提供更高效的数据传输服务,有效提升GPU实例之间的通信效率并缩短任务处理时间。本文介绍如何在GPU实例上配置eRDMA。

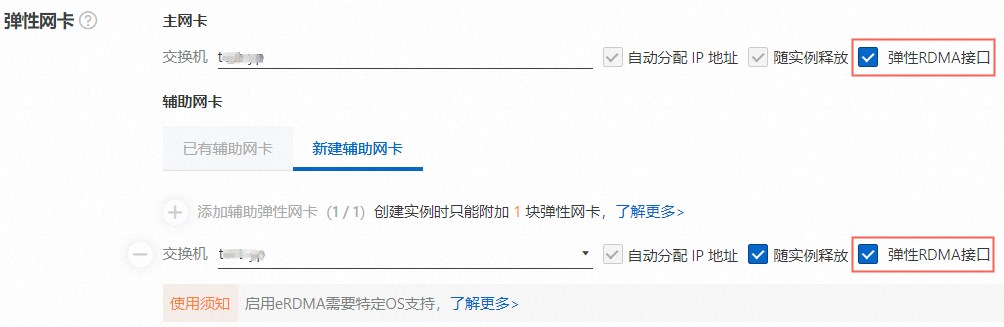

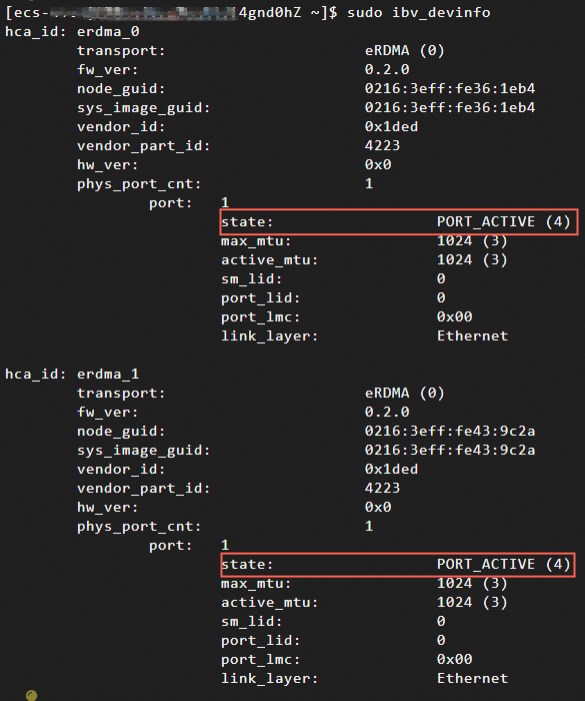

限制项 说明 实例规格 支持ERI的实例规格如下: ebmgn7ex、ebmgn7ix ebmgn8is 镜像 支持以下镜像(任选一款): (推荐)Alibaba Cloud Linux 3 CentOS 8.5/8.4/7.9 Ubuntu 22.04/20.04/18.04 eRDMA设备数量 ebmgn7ix、ebmgn7ex、 ebmgn8is弹性裸金属实例支持2个eRDMA网卡设备。 网络限制 网卡开启弹性RDMA接口后,不支持分配IPv6地址。 两个实例之间通过ERI通信,通信链路中间不支持跨网元设备(例如负载均衡SLB等)。 支持eRDMA能力的实例使能eRDMA能力需满足2个条件:安装了eRDMA软件栈、绑定了开启弹性RDMA接口的网卡。 创建支持ERI的GPU实例。 创建过程中需注意以下配置项(其他参数,请参见自定义购买实例): GPU实例开启后不支持启用或关闭某一弹性网卡的弹性RDMA能力。 开启了弹性RDMA能力后的2张网卡会自动绑定到不同的通道上,无需您单独指定。 主网卡不支持从GPU实例中解绑,只能随GPU实例一起创建和释放。 实例规格:以ebmgn7ex或ebmgn8is为例。 镜像:选择公共镜像时,默认同时选中安装GPU驱动和安装eRDMA软件栈选项,则该实例创建完成后,系统会自动在实例内部安装GPU驱动、CUDA、cuDNN以及eRDMA软件栈。 弹性网卡:创建GPU实例过程中,在带宽和安全组配置向导页面配置弹性网卡时,会默认创建一块eRDMA主网卡和一块eRDMA辅助网卡,并且主网卡和辅助网卡右侧的弹性RDMA接口选项会默认被自动选中。 说明 进入已创建的实例详情页,单击弹性网卡页签,查看实例网卡类型。 主网卡或辅助网卡的网卡类型如下所示,表示该实例已开启了弹性RDMA接口的网卡。 登录ECS管理控制台。 找到目标实例并进入实例详情页,选择弹性网卡页签,查看实例是否已开启了弹性RDMA接口的网卡。 如果已开启,请跳过以下步骤。 如果未开启,请按照以下步骤,为主网卡或者辅助弹性网卡配置eRDMA。 为主网卡或辅助弹性网卡配置eRDMA。 说明 创建GPU实例时,如果主网卡和辅助网卡均未选中弹性RDMA接口,则创建实例后,您可以再单独创建并启用2个eRDMA辅助弹性网卡。 创建GPU实例时,如果主网卡或辅助网卡其中一个网卡未选中弹性RDMA接口,则创建实例后,您只能再单独创建并启用1个eRDMA辅助弹性网卡。 (可选)在实例内使能弹性RDMA网卡(ERI)。 如果选择公共镜像时未选中安装eRDMA软件栈选项,根据实际情况选择脚本方式或者手动方式安装eRDMA软件栈,来使能弹性RDMA网卡(ERI)。 脚本安装方式 手动安装方式 GPU实例创建完成后,您可以通过脚本安装方式单独安装eRDMA软件栈、GPU驱动、CUDA以及cuDNN等软件,脚本示例如下所示。其中,关于 带宽验证。 在Server端执行以下命令,等待Client端的连接请求。 在Client端执行以下命令,发送连接请求和数据包。 其中, 远程连接GPU实例。 具体操作,请参见使用Workbench工具以SSH协议登录Linux实例。 执行以下命令,检查2块eRDMA网卡是否正常。 eRDMA驱动安装脚本默认安装最新版本的驱动,如果您需要安装旧版本eRDMA驱动,请提交工单获取帮助。 本文以eRDMA驱动为0.2.37或以上版本为例,显示结果如下所示,表示2块eRDMA网卡正常存在。其中,2个eRDMA设备的端口 说明 如果eRDMA设备的端口 执行以下命令,安装perftest测试工具。 执行以下命令,测试RDMA网络带宽是否符合对应硬件的预期表现。 说明 上述perftest测试使用了1张网卡通信,如果您业务需要启用2张网卡进行通信,则需要同时启动2个perftest进程,并通过 测试结果包括平均带宽,系统返回信息如下,表示eRDMA通信正常。 为测试和验证配备eRDMA网络的GPU实例在应用中的实际表现,本文以nccl-tests为例,展示如何在实际业务中使用eRDMA的具体操作。关于nccl-tests的更多信息,请参见nccl-tests。 执行以下命令,安装NCCL。 通过下载并编译源码安装NCCL,源码编译的方式如下: 说明 您也可以在NVIDIA官网NVIDIA NCCL下载安装包,然后进行安装。 执行以下命令,安装OpenMPI及编译器。 执行以下命令,设置环境变量。 在实例内部进入 执行以下命令,下载并编译测试代码。 执行以下命令,建立实例之间的SSH互信。 在host1生成公钥后并拷贝到host2上来建立实例之间的SSH互信。 执行如下命令,测试NCCL all_reduce效果。 在企业级ECS实例上配置eRDMA,可实现无需更改业务组网,即可在原有网络下体验超低延迟、大吞吐、高弹性的高性能RDMA网络服务。具体操作,请参见在企业级实例上使用eRDMA。 容器中需要大规模数据传输和高性能网络通信的应用场景中,将eRDMA功能引入容器(Docker)环境可实现容器应用程序绕过操作系统内核直接访问主机的物理eRDMA设备,从而提供更快的数据传输和通信效率。具体操作,请参见在容器(Docker)中使用eRDMA。 如需监测或诊断eRDMA,方便您对eRDMA的运行状态进行实时监控。具体操作,请参见监测和诊断eRDMA。使用限制

操作步骤

创建新GPU实例时配置eRDMA

为已有GPU实例配置eRDMA

DRIVER_VERSION、CUDA_VERSION、CUDNN_VERSION的版本选择,请参见可选版本说明。#!/bin/sh#Please input version to installDRIVER_VERSION="550.90.07"

CUDA_VERSION="12.4.1"

CUDNN_VERSION="9.2.0.82"

IS_INSTALL_eRDMA="TRUE"

IS_INSTALL_RDMA="FALSE"

INSTALL_DIR="/root/auto_install"#using .run to install driver and cudaauto_install_script="auto_install_v4.0.sh"

script_download_url=$(curl http://100.100.100.200/latest/meta-data/source-address | head -1)"/opsx/ecs/linux/binary/script/${auto_install_script}"

echo $script_download_url

rm -rf $INSTALL_DIR

mkdir -p $INSTALL_DIR

cd $INSTALL_DIR && wget -t 10 --timeout=10 $script_download_url && bash ${INSTALL_DIR}/${auto_install_script} $DRIVER_VERSION $CUDA_VERSION $CUDNN_VERSION $IS_INSTALL_RDMA $IS_INSTALL_eRDMAsudo ib_write_bw -d erdma_0 -F -q 16 --run_infinitely --report_gbits -p 18515

sudo ib_write_bw -d erdma_0 -F -q 16 --run_infinitely --report_gbits -p 18515 server_ip

server_ip是Server端ECS实例上绑定eRDMA的弹性网卡所对应的私有IP地址。获取IP地址的方法,请参见查看IP地址。sudo ibv_devinfo

state均为PORT_ACTIVE时,表示eRDMA网卡状态正常。

state为invalid state时,表示该eRDMA网卡状态异常,建议先检查辅助网卡是否配置正确。例如,通过执行ifconfig命令查看所有网卡配置是否存在,所有网卡IP地址是否存在。sudo yum install perftest -y

-d参数为2个进程各指定1张eRDMA网卡、-p参数指定不同的通信端口。更多信息,请参见perftest详情。测试验证

# build ncclcd /root

git clone https://github.com/NVIDIA/nccl.git

cd nccl/

make -j src.lib PREFIX=/usr/local/nccl

make install PREFIX=/usr/local/nccl# 通过ls /usr/local/nccl/lib查看libnccl.so库

wget https://download.open-mpi.org/release/open-mpi/v4.1/openmpi-4.1.3.tar.gz

tar -xzf openmpi-4.1.3.tar.gz

cd openmpi-4.1.3

./configure --prefix=/usr/local/openmpi

make -j && make install

NCCL_HOME=/usr/local/nccl

CUDA_HOME=/usr/local/cuda

MPI_HOME=/usr/local/openmpi

export LD_LIBRARY_PATH=${NCCL_HOME}/lib:${CUDA_HOME}/lib64:${MPI_HOME}/lib:$LD_LIBRARY_PATH

export PATH=${CUDA_HOME}/bin:${MPI_HOME}/bin:$PATH~/.bashrc文件、设置PATH和LD_LIBRARY_PATH,其中,NCCL_HOME、CUDA_HOME、MPI_HOME需要根据实际情况填写。编辑完成后,执行以下命令使环境变量设置生效。source ~/.bashrc

git clone https://github.com/NVIDIA/nccl-tests

cd nccl-tests/

make MPI=1 CUDA_HOME=/usr/local/cuda MPI_HOME=/usr/local/openmpi

#在host1执行ssh-keygen

ssh-copy-id -i ~/.ssh/id_rsa.pub ${host2}

ssh root@{host2} # 在host1执行,测试一下是否可以无密码连接host2。如果是,表示已建立实例之间的SSH互信。# 将host1, host2替换为您对应的IP地址mpirun --allow-run-as-root -np 16 -npernode 8 -H host1:8,host2:8 \

--bind-to none \

-mca btl_tcp_if_include eth0 \

-x NCCL_SOCKET_IFNAME=eth0 \

-x NCCL_DEBUG=INFO \

-x LD_LIBRARY_PATH \

-x PATH \

./build/all_reduce_perf -b 4M -e 4M -f 2 -g 1 -t 1 -n 20

相关文档