在处理大语言模型(LLM)任务中,您可以根据实际业务部署情况,选择在不同环境(例如GPU云服务器环境或Docker环境)下安装推理引擎DeepGPU-LLM,然后通过使用DeepGPU-LLM实现大语言模型(例如Llama模型、ChatGLM模型、百川Baichuan模型或通义千问Qwen模型)在GPU上的高性能推理优化功能。

说明

LLM模型的特性适用于GPU计算型实例,更多信息,请参见GPU计算型(gn/ebm/scc系列)。本文以GPU计算型实例规格gn7i为例。

部分云市场镜像中已预装了DeepGPU-LLM工具,在创建GPU实例时,您可以一键获取预装DeepGPU-LLM的镜像来自动安装DeepGPU-LLM;也可以先购买GPU实例,然后手动安装DeepGPU-LLM。

手动安装方式 容器镜像安装方式 准备Docker环境。 执行以下命令,安装或升级docker-ce。 执行以下命令,安装nvidia-container-toolkit。 如需了解更多信息,请参见Installing the NVIDIA Container Toolkit。 执行以下命令,在Docker环境中拉取并启用Docker镜像。 本示例以拉取 执行以下命令,安装依赖库。 上述命令安装的 安装DeepGPU-LLM。 根据所需的DeepGPU-LLM版本和依赖PyTorch版本,通过 例如 执行以下命令,查看DeepGPU-LLM安装状态及版本。 显示结果如下,表示DeepGPU-LLM已成功安装且当前版本为24.3。pytorch/pytorch:2.1.0-cuda12.1-cudnn8-devel镜像为例。sudo docker pull pytorch/pytorch:2.1.0-cuda12.1-cudnn8-devel

sudo docker run -ti --gpus all --name="deepgpu_llm" --network=host \

-v /root/workspace:/root/workspace \

--shm-size 5g pytorch/pytorch:2.1.0-cuda12.1-cudnn8-devel

apt update

apt install openmpi-bin libopenmpi-dev curl

openmpi-bin提供了OpenMPI、libopenmpi-dev软件包以及curl软件包。pip3 install命令安装DeepGPU-LLM。如何获取最新DeepGPU-LLM版本号,请参见DeepGPU-LLM加速安装包。sudo pip3 install deepgpu_llm=={DeepGPU-LLM版本号}+{PyTorch版本}{CUDA版本} \

-f https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/aiacc-inference-llm/deepgpu_llm.html{DeepGPU-LLM版本号}为24.3、{PyTorch版本}为pt2.1、{CUDA版本}为cu121表示安装24.3版本的DeepGPU-LLM。sudo pip3 install deepgpu_llm==24.3+pt2.1cu121 \

-f https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/aiacc-inference-llm/deepgpu_llm.html

sudo pip list | grep deepgpu-llm

下载模型前,请确认您已成功登录GPU实例。更多信息,请参见连接方式概述。

下载开源模型。

modelscope是阿里达摩院提供的开源模型平台,以下载modelscope格式的通义千问-7B-Chat模型为例,您可以通过以下任一方式下载该模型。

重要

下载模型过程中,如果显示内存不足导致模型下载失败,您可以通过扩容云盘来解决,具体操作,请参见云盘扩容指引。

git lfs clone命令方式

ModelScope库中的snapshot_download方式

进入ModelScope官网,搜索模型名称(例如qwen)。

在搜索页面的模型库区域,单击通义千问-7B-Chat。

找到modelscope的专属模型名并复制模型ID。

执行以下命令,构建下载命令并下载模型ID。

sudo git-lfs clone https://modelscope.cn/qwen/Qwen-7B-Chat.git

说明

下载模型时,如果提示git-lfs: command not found,表示当前系统中未安装git-lfs,请先执行以下命令安装该工具。

sudo apt-get update sudo apt-get install git-lfs

运行Qwen模型推理对话功能。

xxx_cli:脚本名称,请根据DeepGPU-LLM版本替换为相应的具体脚本名称,例如qwen_cli或deepgpu_cli。

[MODEL_DIR]:模型文件所在的目录。请替换为LLM模型成功下载后存放的实际路径。

[TP_SIZE]:推理的GPU数量。

[Type]:推理时使用的精度类型。请根据实际需要选择fp16、int8、int4中的一种精度类型。

24.9版本以下的DeepGPU-LLM提供了xxx_cli脚本(如llama_cli、qwen_cli、baichuan_cli和chatglm_cli等)运行LLM模型。

24.9及以上版本的DeepGPU-LLM提供了deepgpu_cli脚本运行LLM模型。

获取DeepGPU-LLM提供的脚本详细信息,便于运行LLM模型。

DeepGPU-LLM提供了不同脚本帮助您直接运行相应类别的LLM模型,不同版本的DeepGPU-LLM提供的脚本不同,具体如下所示:

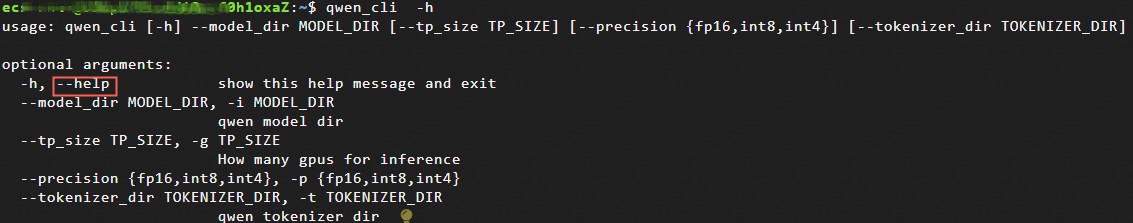

您可以执行xxx_cli -h或deepgpu_cli -h命令获取DeepGPU -LLM所提供的脚本信息。例如执行qwen_cli -h获取qwen_cli脚本的使用帮助信息。

执行以下命令,使用脚本运行Qwen模型推理对话功能。

xxx_cli --model_dir [MODEL_DIR] --tp_size [TP_SIZE] --precision [Type]

以运行qwen_cli脚本加载qwen-7b-chat模型或qwen1.5-7b-chat模型推理进行对话为例。

(可选)模型转换并运行模型推理对话功能。

对于某些受限场景,可以提前做好模型转换,然后部署运行模型的推理对话功能即可。本步骤以qwen1.5-7b-chat模型为例。

转换模型格式。

huggingface_model_convert --in_file /root/Qwen1.5-7B-Chat --saved_dir /root/qwen1.5-7b-chat --infer_gpu_num 1 --weight_data_type fp16 --model_name qwen1.5-7b-chat

执行以下命令,运行Qwen模型推理对话功能。

qwen_cli --tokenizer_dir /root/Qwen1.5-7B-Chat --model_dir /root/qwen1.5-7b-chat/1-gpu/ --tp_size 1 --precision fp16

问题:在Ubuntu 20.04系统上GPU上,执行以下命令安装DeepGPU-LLM时失败。

apt-get update apt-get -y install python3-pip openmpi-bin libopenmpi-dev curl vim pip3 install deepgpu_llm -f https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/aiacc-inference-llm/deepgpu_llm.html

原因及措施:由于apt无法直接安装python 3.10,直接放弃python 3.10安装,安装其他组件即可。安装过程中可能会被动安装gdm3模块导致系统变为图形界面,而非默认的命令行,您可以通过以下命令关闭。

systemctl disable gdm3 reboot

如果您在安装和使用DeepGPU-LLM过程中遇到问题,欢迎加入钉钉群23210030587寻求帮助(钉钉通讯客户端下载地址)。