应用场景

DDoS原生防护企业版主要提供针对三层和四层流量型攻击的防御服务。当流量超出DDoS原生防护企业版的默认清洗阈值后,自动触发流量清洗,实现DDoS攻击防护。概述DDoS原生防护企业版适用于部署在阿里云上的业务,能够满足业务规模大、对网络质量要求高的用户。此类型用户虽然遭受DDoS攻击风险较低,但是如果遭受DDoS攻击导致业

2026-01-23

浏览:1000+

什么是DDoS原生防护

DDoS原生防护是一款直接提升阿里云产品DDoS防御能力的安全产品,部署简单无需改变网络架构,没有四层端口、七层域名数等限制。购买实例并绑定IP后即可分钟级生效。主要防御三层和四层的流量型DDoS攻击,尤其适合希望以低成本、零改造方式快速提升基础DDoS防御能力的用户。前置概念DDoS攻击:全称为分布式拒绝服务攻击(Dist

2026-01-23

浏览:1000+

售前常见问题

阿里云基于多年的DDoS攻防经验和安全技术,提供多款正式商用的DDoS防护解决方案供您选择,满足业务中对各类DDoS攻击进行安全防护的需求。本文介绍如何选择合适的DDoS防护解决方案。视频指导如何选择DDoS防护产品DDoS防护解决方案阿里云提供的DDoS防护解决方案包括免费的DDoS基础防护和以下收费服务:DDoS原生防护、DDoS高防

2026-01-22

浏览:1000+

遭受攻击后如何向网监报案

如果您的业务遭受网络攻击(例如DDoS攻击),除了使用相关安全服务(例如DDoS高防IP、云安全中心等)来保障您的业务安全与稳定,建议您同时向网监部门进行报案。报案流程遭受攻击后,您应该尽快向当地网监部门进行报案,并根据网监部门要求提供相关信息。网监部门判断是否符合立案标准,并进入网监处理流程。说明具体立案标

2026-01-22

浏览:1000+

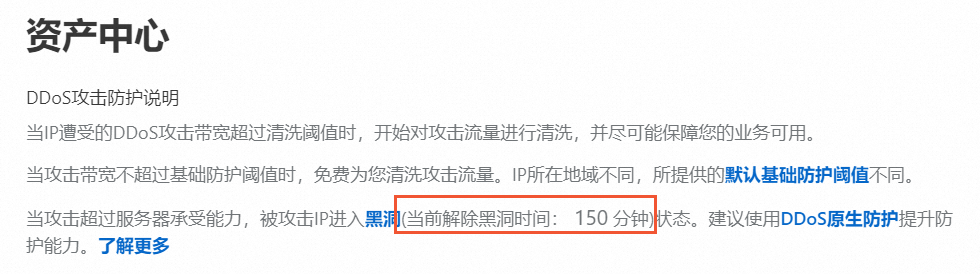

阿里云黑洞策略

当阿里云产品遭受大流量DDoS攻击且攻击流量的峰值带宽(bps)超过了其DDoS防御能力时,为避免DDoS攻击对云产品产生更大损害,同时也避免单个云产品被DDoS攻击而影响其他资产正常运行,阿里云黑洞策略会暂时阻断阿里云产品与互联网之间的流量交互,正常网络通信会受到影响。本文介绍如何预防和处理黑洞。DDoS基础防御能力购买

2026-01-22

浏览:1000+

DDoS攻击解缓方案

分布式拒绝服务攻击(DDoS攻击)是一种针对目标系统的恶意网络攻击行为,DDoS攻击经常会导致被攻击者的业务无法正常访问,也就是所谓的拒绝服务。常见攻击类型攻击类型常见方式攻击特征网络层攻击UDP反射攻击,例如NTP Flood攻击。主要利用大流量拥塞被攻击者的网络带宽,导致被攻击者的业务无法正常响应客户访问。传输层攻

2026-01-21

浏览:1000+

功能特性

DDoS高防功能集功能功能描述参考文档安全总览安全总览业务及攻击流量趋势图、告警事件、连接数趋势及业务流量区域分布。安全总览接入管理域名接入配置网站业务接入DDoS高防后的流量转发信息后,DDoS高防才能为网站防御DDoS攻击。域名接入端口接入非网站业务(例如客户端应用程序)接入DDoS高防时,需要配置端口转发规则,使

2026-01-21

浏览:1000+

什么是DDoS攻击

分布式拒绝服务(Distributed Denial of Service,简称DDoS)是指将多台计算机联合起来作为攻击平台,通过远程连接,利用恶意程序对一个或多个目标发起DDoS攻击,消耗目标服务器性能或网络带宽,从而造成服务器无法正常地提供服务。DDoS攻击原理DDoS攻击核心在于利用僵尸网络(Botnet)进行协同攻击:攻击者通过非法手段控制

2026-01-21

浏览:1000+

如何选择DDoS防护产品

阿里云基于多年的DDoS攻防经验和安全技术,提供多款正式商用的DDoS防护解决方案供您选择,满足业务中对各类DDoS攻击进行安全防护的需求。本文介绍如何选择合适的DDoS防护解决方案。视频指导如何选择DDoS防护产品DDoS防护解决方案阿里云提供的DDoS防护解决方案包括免费的DDoS基础防护和以下收费服务:DDoS原生防护、DDoS高防

2026-01-20

浏览:1000+

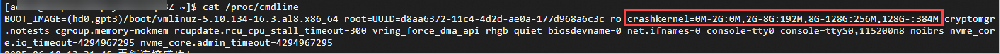

释放Linux服务器的预留内存

Kdump是Linux的内核崩溃转储机制,能在系统崩溃(如内核panic)时捕获内存信息,便于事后故障分析,该机制需要预留内存(称为crashkernel)来保存转储信息。如果您的Linux服务器内存较小,可参考本文档关闭kdump释放预留内存,提高内存的利用率。操作步骤重要释放系统预留内存并关闭Kdump服务,在系统故障时可能无法收集内核

2026-01-20

浏览:1000+