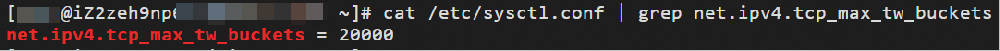

Linux系统常用内核网络参数介绍与常见问题处理

本文介绍常见的Linux系统内核网络参数及常见问题的解决方案。注意事项在修改内核参数前,您需要注意以下几点:从实际需求出发,尽量有相关数据的支撑,不建议您随意调整内核参数。了解参数的具体作用,需注意不同类型或版本的环境中,内核参数可能有所不同。备份轻量应用服务器实例中的重要数据。具体操作,请参见创建快照。

2026-01-08

浏览:1000+

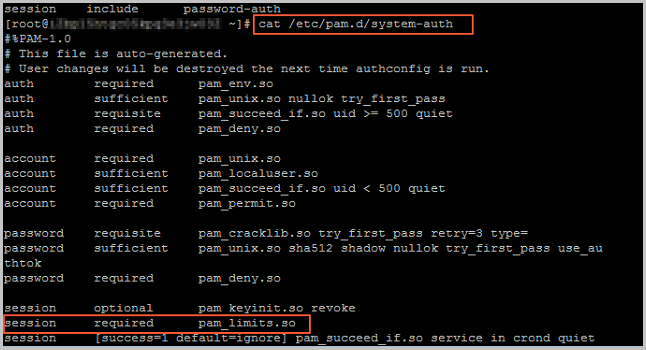

登录Linux服务器失败并报“login: Module is unknown”错误如何处···

本文介绍登录Linux实例失败并报“login: Module is unknown”错误时的问题原因和解决方案。问题描述登录Linux实例失败并且在secure日志中出现类似以下报错信息。login:Moduleisunknown.login:PAMunabletodlopen(/lib/security/pam_limits.so):/lib/security/pam_lim

2026-01-07

浏览:1000+

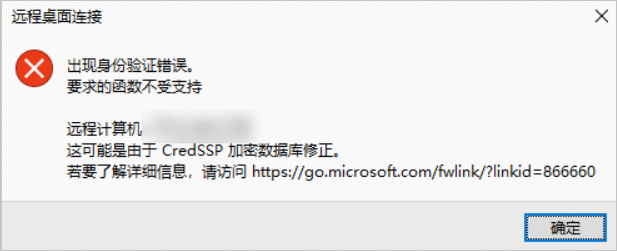

远程连接轻量应用服务器提示“出现身份验证错误,要求的函数不受···

本文介绍远程连接轻量应用服务器提示“出现身份验证错误,要求的函数不受支持”的问题描述、问题原因及其解决方案。问题描述本地电脑使用远程桌面连接工具连接Windows系统的轻量应用服务器时,提示“出现身份验证错误,要求的函数不受支持”。问题原因微软官方于2018年5月,更新了凭据安全支持提供程序协议(CredSSP)相关补

2026-01-07

浏览:1000+

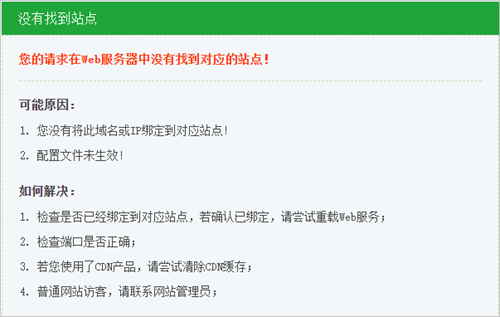

访问基于宝塔面板搭建运行环境以及网站程序提示“您的请求在Web服···

本文主要介绍访问基于宝塔面板搭建运行环境以及网站程序提示“您的请求在Web服务器中没有找到对应的站点”报错的问题描述、问题原因及其解决方案。问题描述在阿里云轻量应用服务器中,访问基于宝塔面板搭建运行环境以及网站程序后,提示以下报错。您的请求在Web服务器中没有找到对应的站点具体报错如下图所示。问题原

2026-01-07

浏览:1000+

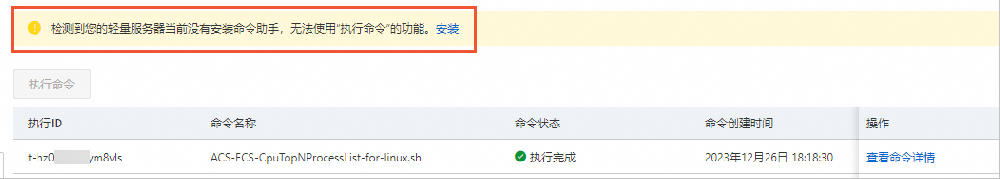

云助手Agent卸载或者停止后,命令助手等功能出现异常,如何解决?···

本文主要介绍云助手Agent卸载或者停止后,命令助手等功能出现异常的问题描述、问题原因及其解决方案。问题描述手动卸载或者停止轻量应用服务器中的云助手Agent,使用命令助手等功能时,会出现功能异常。以使用命令助手为例,报错信息如下图所示。问题原因轻量应用服务器的命令助手和HTTPS设置依赖于云助手Agent,如果您停止

2026-01-06

浏览:1000+

在轻量应用服务器控制台中不显示服务器的内存和磁盘的使用信息

本文主要介绍在轻量应用服务器控制台中不显示服务器的内存和磁盘的使用信息的问题描述、问题原因及其解决方案。问题描述在阿里云轻量应用服务器控制台中,查看轻量应用服务器的监控信息时,不显示内存和系统盘的使用信息。问题原因在轻量应用服务器管理控制台中,服务器的内存和系统盘数据通过云监控插件获取,当您进行重置

2026-01-06

浏览:1000+

轻量应用服务器网速较慢与预期带宽不符

本文介绍轻量应用服务器网速较慢与预期带宽不符的问题描述、问题原因及其解决方案。问题描述访问阿里云轻量应用服务器中的网站或应用,出现网络访问过慢的情况,与设置的预期带宽不符。问题原因服务器的地域为中国香港。 中国内地访问中国香港以及海外地域部分轻量应用服务器,出现网络无法连通的情况(海外客户端访问正常)

2026-01-06

浏览:1000+

使用自定义镜像创建轻量应用服务器失败

本文主要介绍使用自定义镜像创建轻量应用服务器失败的问题描述、问题原因及其解决方案。问题描述在轻量应用控制台中,使用自定义镜像创建服务器失败。问题原因不符合重置镜像的条件或者删除自定义镜像相关的资源。解决方案检查是否满足重置镜像的条件。重置镜像的使用限制,请参见使用限制。检查是否删除自定义镜像相关的资

2026-01-05

浏览:1000+

重置轻量应用服务器的密码后未生效

本文主要介绍重置轻量应用服务器的密码后未生效的问题描述、问题原因及其解决方案。问题描述在阿里云轻量应用服务器控制台中,重置轻量应用服务器的密码后未生效。问题原因重置密码之后未重启轻量应用服务器。第三方安全软件对系统文件进行加固,导致密码无法修改成功。在控制台修改非管理员用户名的密码。不同操作系统的服

2026-01-05

浏览:1000+

远程连接非中国内地的轻量应用服务器提示连接超时

本文介绍远程连接非中国内地的轻量应用服务器提示连接超时的问题描述、问题原因及其解决方案。问题描述通过远程连接登录非中国内地的阿里云轻量应用服务器失败,并提示连接超时。问题原因如果您在中国内地访问其他国家和地区地域下的轻量应用服务器,可能会出现较大延迟及丢包,造成无法访问轻量应用服务器的情况。该问题受

2026-01-05

浏览:1000+