存储桶标签 - bucket-tagging

注意: 如需获取存储桶标签,在您进行 授权策略 时,action 需要设置为 cos:GetBucketTagging。 如需设置存储桶标签,在您进行 授权策略 时,action 需要设置为 cos:PutBucketTagging。 如需删除存储桶标签,在您进行 授权策略 时,action 需要设置为 cos:DeleteBucketTagging。更多授权请参见 支持 CAM 的业务接口。命令格

2025-10-23

浏览:1000+

删除存储桶 - rb

注意:如需使用此命令,在您进行 授权策略 时,action 需要设置为 cos:DeleteBucket ,更多授权请参见 支持 CAM 的业务接口。命令格式./coscli rb cos://<bucket-name> [flag]rb 命令包含以下参数:参数格式参数用途示例cos://<bucket-name>指定需要访问的存储桶。支持使用 配置参数 中的桶别名,或桶名称进行访

2025-10-23

浏览:1000+

创建存储桶 - mb

mb 命令用于创建存储桶。注意:如需使用此命令,在您进行 授权策略 时, action 需要设置为 cos:PutBucket ,更多授权请参见 支持 CAM 的业务接口。命令格式./coscli mb cos://<BucketName-APPID> -e <endpoint> [flag]注意:使用 mb 命令创建存储桶,需要携带全局 flag -e 或 --endpoint 指定存储桶所在地域。

2025-10-22

浏览:1000+

生成与修改配置文件 - config

以下 config 命令用于生成与修改配置文件:./coscli config [command] [flag]说明正确填写各配置项后,您可以使用./coscli config show 来查看配置信息。关于此命令的其他通用选项(例如切换存储桶、切换用户账号等),请参见 通用选项 文档。生成的配置文件,默认网络传输协议为 https。如需更改为 http,可直接进入配置文

2025-10-22

浏览:1000+

通用选项

./coscli --help 或 ./coscli -h 命令查看 COSCLI 支持的通用选项。选项说明以下为 COSCLI 的通用选项,这些选项可以在工具的所有命令中使用:注意:建议用户通过 临时密钥 使用工具,通过临时授权的方式进一步提高工具使用的安全性。申请临时密钥时,请遵循 最小权限指引原则,防止泄露目标存储桶或对象之外的资源。如果您

2025-10-22

浏览:1000+

下载与安装配置

COSCLI 工具提供 Windows、macOS、Linux 操作系统的二进制包,通过简单的安装和配置后即可使用。步骤一:下载 COSCLI 工具您可以根据业务场景选择下载 COSCLI 工具的地址。如果您的服务器在国内,推荐使用国内站点下载地址(此处链接的工具版本均为最新版本,如需使用旧版本,可访问 release 获取历史版本)。国内站点下载地

2025-10-21

浏览:1000+

COSCLI 简介

COSCLI 是腾讯云对象存储(Cloud Object Storage,COS)提供的客户端命令行工具。通过 COSCLI 工具,您可以通过简单的命令行指令对您 COS 中的对象(Object)实现批量上传、下载、删除等操作。COSCLI 使用 Go 编写,基于 Cobra 框架,支持配置多个存储桶和跨桶操作。您可以通过 ./coscli [command] --help 来查看 COSCLI 的

2025-10-21

浏览:1000+

COSCMD 工具

使用 COSCMD 工具,用户可通过简单的命令行指令实现对对象(Object)的批量上传、下载、删除等操作。使用环境系统环境支持 Windows、Linux 和 macOS 系统。说明:请保证本地字符格式为 UTF-8,否则操作中文版的文件会出现异常。请确保本机时间已经与国际标准时间校准,如误差过大,将导致无法正常使用。软件依赖Python 2.7和

2025-10-21

浏览:1000+

COS 终端网络诊断工具使用指南

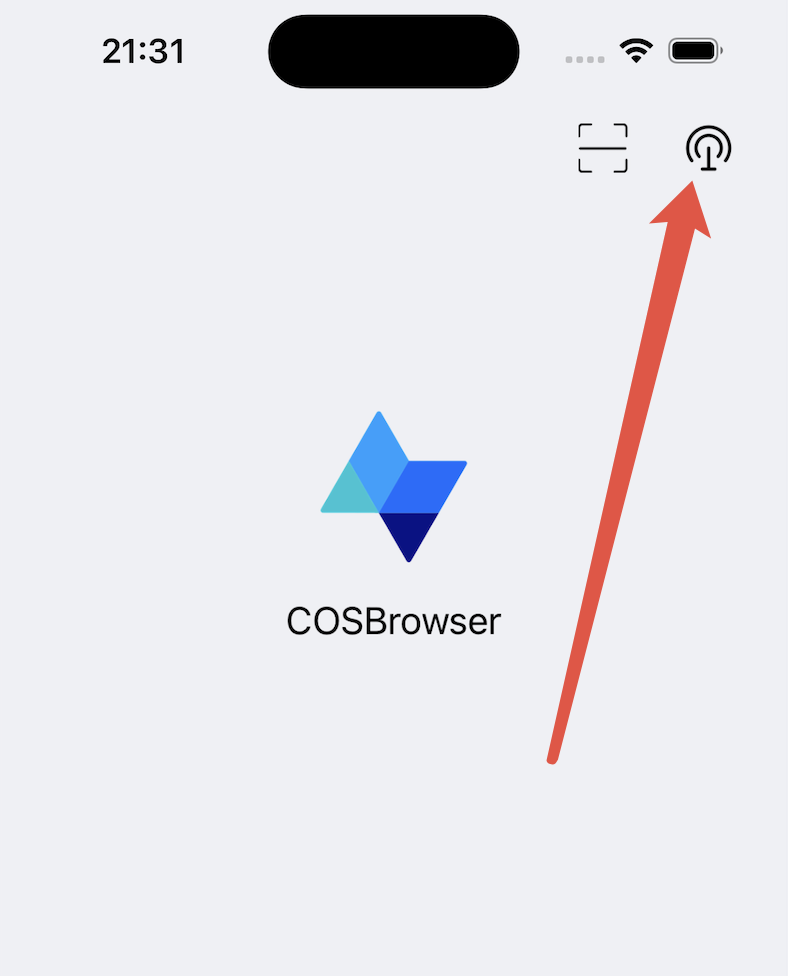

工具简介COS 终端网络诊断工具是集成在 COSBrowser 中,对终端到 COS 的网络链路进行排障的工具,它可以通过网络探测和传输测速进行真实的网络链路检测,并给出检测的结论和日志。本文将指导您如何使用这款工具进行网络诊断。使用场景 当您的 APP 在移动端使用 COS 服务时遇到错误或者上传、下载慢的问题时,可以用该工具进

2025-10-20

浏览:1000+

资源包管理

简介COSBrowser 移动端提供了查看资源包列表、购买、续费、升级等操作。说明:关于资源包的类型介绍、购买须知、有效期以及生效范围,请参见 资源包介绍。通过移动端购买、续费、升级资源包需要跳转到云助手小程序进行操作,在进行相关操作之前请确保 COSBrowser 移动端和腾讯云助手小程序登录的是同一个腾讯云账号。查看资

2025-10-20

浏览:1000+