COSBrowser 简介

COSBrowser 是腾讯云对象存储 COS 推出的可视化界面工具,让您可以使用更简单的交互,轻松实现对 COS 资源的查看、传输和管理。若迁移数据,或批量上传数据,请使用 云迁移(Cloud Migration,CMG)。目前 COSBrowser 有桌面端和移动端两种,详情可参见:桌面端使用说明移动端使用说明下载地址COSBrowser 分类

2025-10-10

浏览:1000+

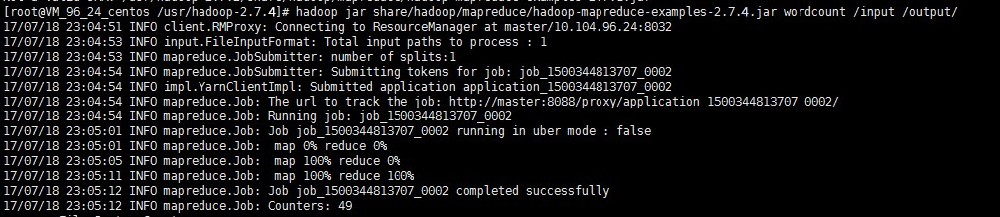

Hadoop 安装与测试

Hadoop 工具依赖 Hadoop-2.7.2 及以上版本,实现了以腾讯云对象存储(Cloud Object Storage,COS)作为底层存储文件系统运行上层计算任务的功能。启动 Hadoop 集群主要有单机、伪分布式和完全分布式等三种模式,本文主要以 Hadoop-2.7.4 版本为例进行 Hadoop 完全分布式环境搭建及 wordcount 简单测试介绍。准备环境1. 准备

2025-10-10

浏览:1000+

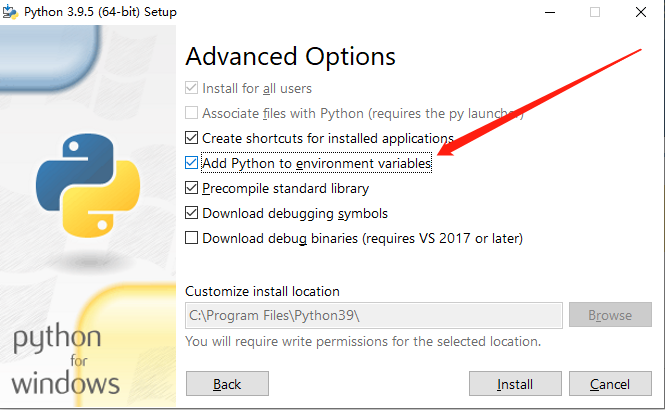

Python 安装与配置

通过安装包安装1. 下载进入 Python 官方网站,根据自己使用的操作系统,选择下载合适的安装包。注意:Python 官方已于2020年1月1日停止对 Python2 的维护,建议安装使用 Python3。2. 安装下载安装包后,根据安装包的引导即可完成 Python 开发环境的安装。说明:Windows 系统用户在安装时要注意勾选"Add Python to envi

2025-10-09

浏览:1000+

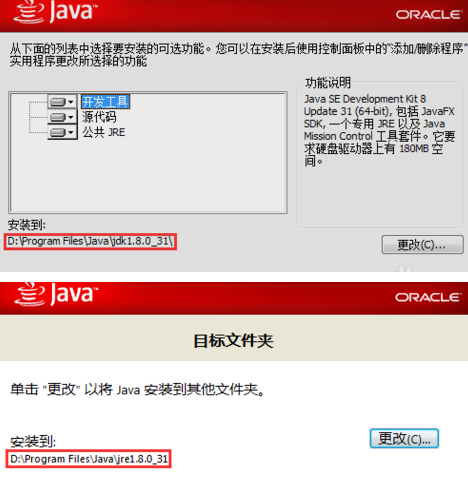

Java 安装与配置

Windows1. 下载 JDK进入 Oracle 官方网站 下载合适的 JDK 版本。2. 安装根据提示一步步安装,安装过程中可以自定义安装目录(默认安装到 C 盘),例如我们选择的安装目录为:D:\Program Files\Java\jdk1.8.0_31和D:\Program Files\Java\jre1.8.0_31。3. 配置安装完成后,右键单击计算机 > 属性 > 高级系统设置

2025-10-09

浏览:1000+

工具概览

工具功能说明COSBrowser 工具本工具支持多种操作系统,提供可视化界面,可方便用户进行数据上传、下载、生成访问链接等操作。COSCLI 工具本工具是一款客户端命令行工具,提供多种常用命令,您可以使用简单的命令行指令实现对象批量上传、同步上传、同步下载、删除等操作。COSCMD 工具本工具是另一款客户端命令行工具,可

2025-10-09

浏览:1000+

手动续费容器服务

创建容器服务时支持设置自动续费,您也可以在创建容器服务后,手动续费容器服务。本文介绍如何手动续费容器服务。背景信息容器服务到期后将会自动关机。从到期时间开始计算,15天内容器服务的状态显示为已禁用,该状态下容器不支持公网访问,您只需要续费容器服务即可启动容器服务。如果在15天内您没有续费容器服务,容器服

2025-09-30

浏览:1000+

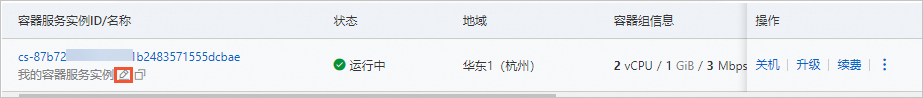

修改容器服务名称

当您创建容器服务后,可以修改容器服务的名称,便于您识别及其统一管理。本文介绍如何修改容器服务的名称。操作步骤访问轻量应用服务器控制台-容器服务。将鼠标悬浮在目标容器服务实例名称上,单击图标。如果容器服务卡片较多,可在搜索文本框中,输入容器服务实例ID筛选容器服务。在弹出的编辑名称对话框中,输入容器服务名

2025-09-30

浏览:1000+

查看容器概览信息

当您创建容器服务后,可以通过管理控制台查看容器服务的vCPU和内存使用信息、到期时间、容器组数量、容器组规格等信息。本文介绍如何通过管理控制台查看容器服务的概览信息。操作步骤访问轻量应用服务器控制台-容器服务。在容器服务页面,单击容器服务实例ID。如果容器服务较多,可在搜索文本框中,输入容器服务实例ID筛选容

2025-09-30

浏览:1000+

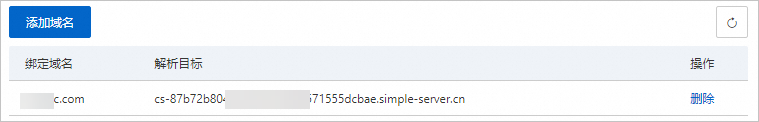

通过域名访问容器

如果您想通过域名来访问容器服务实例,需要将域名和容器服务实例绑定,并将域名解析到该容器服务实例的公网入口地址,这样才能通过域名正常访问该容器服务实例。本文介绍如何为容器服务实例绑定并解析域名。前提条件通过公网可以正常访问容器服务,容器部署时需要设置某个容器来响应公网访问。具体操作,请参见部署容器。已

2025-09-29

浏览:1000+

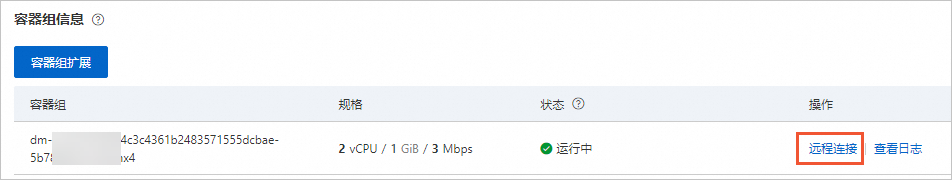

远程连接容器

部署容器后,您可以在轻量应用服务器管理控制台远程连接容器并对其进行相关管理。本文介绍如何远程连接容器。操作步骤访问轻量应用服务器控制台-容器服务。在容器服务页面,单击目标容器服务实例ID。如果容器服务较多,可在搜索文本框中,输入容器服务实例ID筛选容器服务。在概览页签的容器组信息区域,在目标容器组的操作列

2025-09-29

浏览:1000+