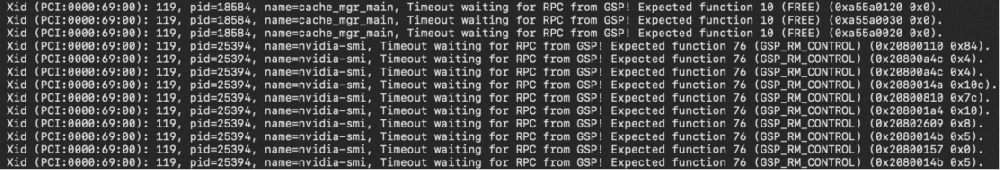

使用GPU时出现XID 119/XID 120错误导致GPU掉卡

在Linux系统上使用GPU时,可能会因为GPU的GSP(GPU System Processor)组件运行状态异常,导致GPU卡在初始化时提示失败(例如出现XID 119或XID 120错误信息),本文为您介绍这种情况的解决方案。问题现象使用GPU时出现GPU掉卡现象,例如在Linux系统上使用GPU时,出现GPU卡初始化失败的错误提示。执行sh nvidia-bug-report.s

2025-07-09

浏览:1000+

GPU云服务器常见问题

为了有效排查和解决GPU云服务器的相关问题,本文为您汇总了使用GPU时遇到的一些常见问题。类别相关问题GPU实例GPU实例支持安卓模拟器吗?GPU实例的配置支持变更吗?普通ECS实例规格族是否支持升级或变更为GPU实例规格族?如何在GPU实例和普通ECS实例间传输数据?GPU与CPU有什么区别?GPU显卡购买GPU实例后,为什么执行nvidi

2025-07-09

浏览:1000+

通过Docker命令行使用cGPU服务

使用cGPU服务可以隔离GPU资源,实现多个容器共用一张GPU卡。该服务作为阿里云容器服务Kubernetes版ACK(Container Service for Kubernetes)的组件对外提供服务,应用于高性能计算能力的场景,例如机器学习、深度学习、科学计算等,方便您更高效地利用GPU资源,以加速计算任务。本文介绍如何通过安装并使用cGPU服务。说明cG

2025-07-09

浏览:1000+

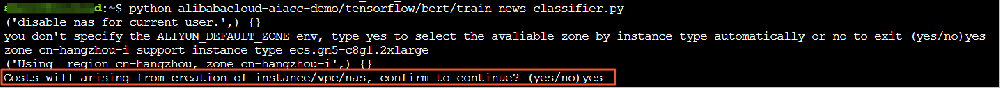

命令行使用说明

您可以通过FastGPU的命令行,快速地部署云上GPU集群,管理资源的生命周期。还可以便捷地为集群安装深度学习环境,在集群运行代码,查看运行日志以及释放资源。前提条件客户端已安装Python 3.6或以上版本。说明您的ECS实例、本地机器、阿里云Cloud Shell工具等均可以作为客户端安装FastGPU来构建人工智能计算任务。已获取阿里

2025-07-08

浏览:1000+

Python SDK使用说明

您可以通过FastGPU提供的Python接口,将FastGPU集成到您的人工智能训练或推理脚本中,从而快速地实现云上部署和资源管理。本文为您介绍FastGPU的Python SDK相关使用说明。前提条件客户端已安装Python 3.6或以上版本。说明您的ECS实例、本地机器、阿里云Cloud Shell工具等均可以作为客户端安装FastGPU来构建人工智能计算任务

2025-07-08

浏览:1000+

安装并使用FastGPU构建一键训练任务

前提条件客户端已安装Python 3.6或以上版本。说明您的ECS实例、本地机器和阿里云Cloud Shell工具等均可以作为客户端安装FastGPU来构建人工智能计算任务。背景信息FastGPU提供以下两套组件:运行时组件ncluster:提供便捷的接口将线下的人工智能训练和推理脚本快速部署在阿里云的IaaS资源上,更多运行时组件使用说明请参见Py

2025-07-08

浏览:1000+

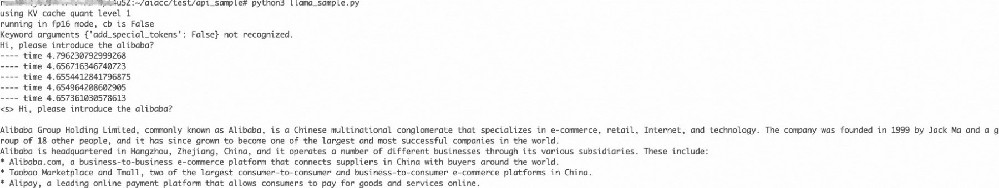

DeepGPU-LLM的API接口说明及示例

DeepGPU-LLM作为阿里云开发的一套推理引擎,旨在优化大语言模型在GPU云服务器上的推理过程,为您提供免费的高性能、低延迟推理服务。DeepGPU-LLM提供了一系列的API接口(例如模型加载、模型推理等功能),在GPU云服务器上成功安装DeepGPU-LLM后,您可以调用对应API接口进行模型推理服务,快速提高模型的推理效率和准确性。说

2025-07-07

浏览:1000+

安装并使用DeepGPU-LLM

在处理大语言模型(LLM)任务中,您可以根据实际业务部署情况,选择在不同环境(例如GPU云服务器环境或Docker环境)下安装推理引擎DeepGPU-LLM,然后通过使用DeepGPU-LLM实现大语言模型(例如Llama模型、ChatGLM模型、百川Baichuan模型或通义千问Qwen模型)在GPU上的高性能推理优化功能。说明LLM模型的特性适用于GPU计算型实

2025-07-07

浏览:1000+

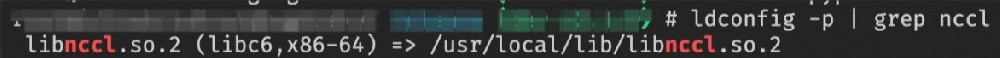

安装并使用DeepNCCL

DeepNCCL是阿里云神龙异构产品开发的用于多GPU互联的AI通信加速库,能够无感地加速基于NCCL进行通信算子调用的分布式训练或多卡推理等任务。开发人员可以根据实际业务情况,在不同的GPU云服务器上安装DeepNCCL通信库,以加速分布式训练或推理性能。本文主要介绍在Ubuntu或CentOS操作系统的GPU实例上安装和使用DeepNCCL的操作

2025-07-07

浏览:1000+

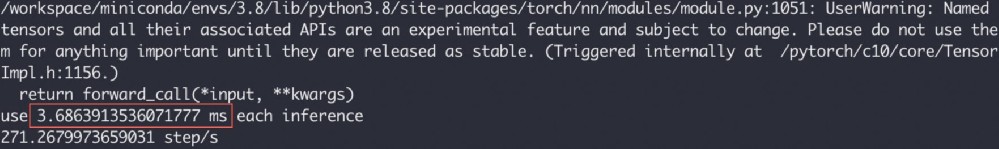

安装和使用Deepytorch Inference

Deepytorch Inference是阿里云自研的AI推理加速器,针对Torch模型,可提供显著的推理加速能力。本文主要介绍安装并使用Deepytorch Inference的操作方法,以及推理效果展示。背景信息Deepytorch Inference通过调用deepytorch_inference.compile(model)接口即可实现推理性能加速。使用DeepytorchInference前,您需要先使

2025-06-27

浏览:1000+